반응형

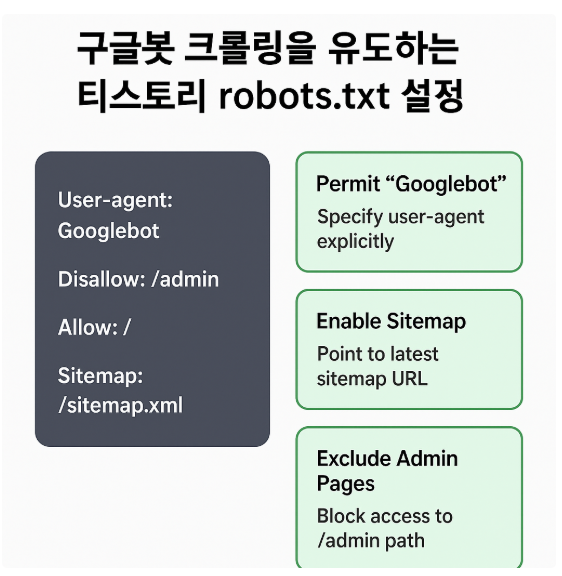

구글봇 크롤링을 유도하는 티스토리 robots.txt 설정

robots.txtGooglebot크롤링 최적화사이트맵파라미터티스토리 SEO

개요: robots.txt의 역할과 한계

robots.txt는 크롤러에게 “어디를 수집해도 좋은지” 신호를 주는 크롤링 제어 파일입니다. 단, 인덱싱 금지를 보장하는 장치는 아니므로 민감한 URL은 noindex(메타/HTTP)로 처리해야 합니다.

핵심: 중요한 페이지는 허용(Allow)과 사이트맵으로 노출을 돕고, 중복/필요 없는 경로는 Disallow로 크롤링 낭비를 줄입니다.

티스토리 추천 기본 규칙

아래는 티스토리 환경에서 안전하게 시작할 수 있는 기본안입니다. 도메인과 피드/검색/태그 등 불필요한 영역을 정리했습니다.

# /robots.txt (티스토리 사용자 도메인 기준)

User-agent: *

# 핵심: 글 본문/카테고리/태그 개별 글은 허용

Allow: /category/

Allow: /entry/

Allow: /m/entry/

# 크롤링 낭비가 큰 영역 제한

Disallow: /search

Disallow: /tag

Disallow: /admin

Disallow: /manage

Disallow: /notice

Disallow: /commentOnly

Disallow: /*?page=

Disallow: /*?amp=*

Disallow: /*?replyAll=*

Disallow: /*?category=*

Disallow: /attachment/

# 사이트맵 연결(티스토리에서 제공되는 RSS/Atom 또는 자체 생성 XML)

Sitemap: https://도메인/sitemap.xml

Sitemap: https://도메인/rss

주의: AMP나 모바일 전용 중복 버전을 운영한다면 하나의 정식 URL에

canonical을 고정하고, 불필요 파라미터는 차단하세요.중복 URL/파라미터 처리

티스토리는 목록/페이지네이션/검색/정렬 파라미터가 붙어 중복 URL이 쉽게 만들어집니다. 다음과 같은 패턴을 우선 정리합니다.

| 유형 | 예시 | 권장 조치 |

|---|---|---|

| 페이지네이션 | ?page=2 |

Disallow 또는 내부 링크 최소화 |

| 검색 결과 | /search?q=키워드 |

Disallow, 개별 글로 유도 |

| 태그 리스트 | /tag/키워드 |

리스트는 차단, 글 본문은 허용 |

| 임시/댓글 전용 | replyAll, commentOnly |

Disallow |

팁: 중복 제어는 세 가지를 함께 사용하면 안전합니다:

robots.txt + rel=canonical + 필요 시 noindex.사이트맵 연결과 크롤링 힌트

티스토리는 기본 RSS/Atom이 있으나, 가능하면 sitemap.xml을 생성해 최신 글·우선순위·변경일을 전달하세요.

<!-- <head> 내부 링크 예시 -->

<link rel="canonical" href="https://도메인/entry/슬러그" />

# robots.txt 하단

Sitemap: https://도메인/sitemap.xml

점검 도구

- 검색 콘솔 ▶ robots.txt 테스터, URL 검사, 크롤링 통계

- 서버 응답 확인:

/robots.txt가 HTTP 200으로 제공되는지 점검

이미지 슬롯·OG·ALT 규칙

- 대표 썸네일(OG): 1200×630, 대비 높은 색 + 12~16자 핵심 문구.

- 본문 이미지: WebP,

width/height명시,loading="lazy". - ALT: 이미지를 보지 못해도 이해되는 1문장(키워드 1회, 과밀 금지).

점검 루틴(월간)

- 크롤링 통계: 크롤링 요청/응답 상태 변화를 확인

- 인덱싱 보고서: 제외 사유(크롤링됨-현재 인덱스 미포함 등) 점검

- 상위 URL: “발견되었으나 크롤링 안 됨” URL을 중심으로 내부 링크 보강

- 변경 기록: robots.txt/사이트맵 변경 시 날짜·사유를 노트에 기록

팁: 큰 구조 변경 전에는 스테이징 블로그나 임시 서브도메인에서 먼저 테스트하세요.

지표: 크롤링/인덱싱/트래픽

- 크롤링 효율: 허용 URL 대비 200 응답 비율, 평균 응답 시간

- 인덱싱 커버리지: 제출된 URL 대비 인덱스 비율

- 성과: 신규 인덱스 수 →

CTR→view_second_post의 연쇄

| 문제 | 징후 | 해결 액션 |

|---|---|---|

| 크롤링 낭비 | /search, /tag 요청 과다 | Disallow 추가/확인, 내부 링크 정리 |

| 중복 인덱스 | ?page, ?category 파생 URL 노출 | canonical 고정 + Disallow + noindex |

| 인덱싱 지연 | 발행 후 수집 느림 | 사이트맵 ping, 내부 링크 허브 연결 강화 |

배포 전 체크리스트

/robots.txt가 HTTP 200으로 제공되는가?- 핵심 경로(

/entry/,/category/)는 Allow, 낭비 경로(/search,?page=)는 Disallow인가? - 사이트맵 경로가 유효하며 최신 글이 포함되는가?

- 중복/민감 URL은

canonical/noindex로 보완했는가? - 변경 후 검색 콘솔에서 테스트 및 제출을 완료했는가?

최종 정리

티스토리에서의 robots.txt는 중복/낭비 크롤링을 줄이고 핵심 문서를 우선 수집하도록 돕는 장치입니다. 허용/차단을 명확히 하고, 사이트맵·canonical·noindex와 역할을 분담하면 Googlebot이 더 빠르게, 더 정확히 콘텐츠를 파악합니다. 변경 시 기록을 남기고 월간 루틴으로 지표를 확인하세요.

반응형

'애드센스 & 수익화' 카테고리의 다른 글

| 2025년 티스토리 저품질 알고리즘 패턴 분석 (0) | 2025.10.21 |

|---|---|

| 실전 HTML/CSS로 티스토리 스킨 사용자 맞춤 디자인하기 (0) | 2025.10.20 |

| 티스토리 + 뉴스 API 연동 자동 요약 포스팅 실험 (0) | 2025.10.20 |

| 애드센스 수익률 높은 주제 선정법 (데이터 기반) (0) | 2025.10.19 |

| 애드센스 수익률 높은 주제 선정법 (데이터 기반) (0) | 2025.10.18 |